#100 Degenerace AI modelu a digitální azbest

Jak bude fungovat učení AI, která se bude učit na svých vlastních textech? Jako když se děti ve škole učí divadlo...sami od sebe... a ještě hůře. Co nového v technice?

Dobrý den,

vítejte u prvního letošního prázdninového newsletteru a zároveň kulatého stého čísla mého newsletteru. První číslo newsletteru vyšlo 13.10.2020 a mimo jiné jsem v něm tehdy měl rubriku Slovec nakonec, v níž jsem napsal:

Zajímavé slovo na závěr, jemuž byste měli věnovat pozornost. To je Slovec Nakonec. Co je GPT-3? Autoregresivní jazykový model, který používá hluboké učení k tomu, aby produkoval texty těžko rozlišitelné od lidských. Stojí za ním OpenAI, která jej natrénovala na obrovském množství textů a výsledky jsou zajímavé. Věnujte tomu pozornost, hrajte si. Jo, OpenAI založil Elon Musk a získalo miliardovou investici v dolarech od Microsoftu. Má to být neziskovka na výzkum neškodlivého strojového učení, pročtěte si dobré heslo na Wikipedii.

To tak nějak klaplo, snad jste tomu věnovali pozornost... 😎

A proč to jméno? V té době všichni dávali svým newsletterům fancy jména a já měl sice text, ale už jsem neměl sílu vymýšlet nic fancy a invenčního. Do doby, než mne osvítí nějaký cool nápad, zůstaneme u toho, že se to tu jmenuje Patrickův newsletter.

A placené předplatné newsletteru? Běží, co mne příjemně překvapilo, že si toho řada čtenářů všimla a konvertovala se do placeného předplatného, i když patří do life-time tarifu, kde to mají všechno zdarma, protože patří mezi skalní čtenáře. A budu rád, když pětidolarové předplatné zvolí i další lidé.

O čem bude dneska řeč?

konkurence mezi AI firmami se zahušťuje, po trhu chodí Mark Zuckerberg, šermuje pormonkou a snaží se koupit cokoliv, co by posunulo jeho AI strategii do viditelného spektra. Dočtete se v Situace na digitální AI frontě se zahušťuje

hlavním tématem dnešního newsletteru je ale to, jak se bude AI učit v momentě, kdy bude narážet na sebou produkované (a tedy i smyšlené) materiály. Nepovede to ke stagnaci? Čtěte v AI, degenerace modelu a digitální azbest

Na závěr se podíváme na to, jaký vliv má AI na provoz na webu. Značný. Ale co s tím?

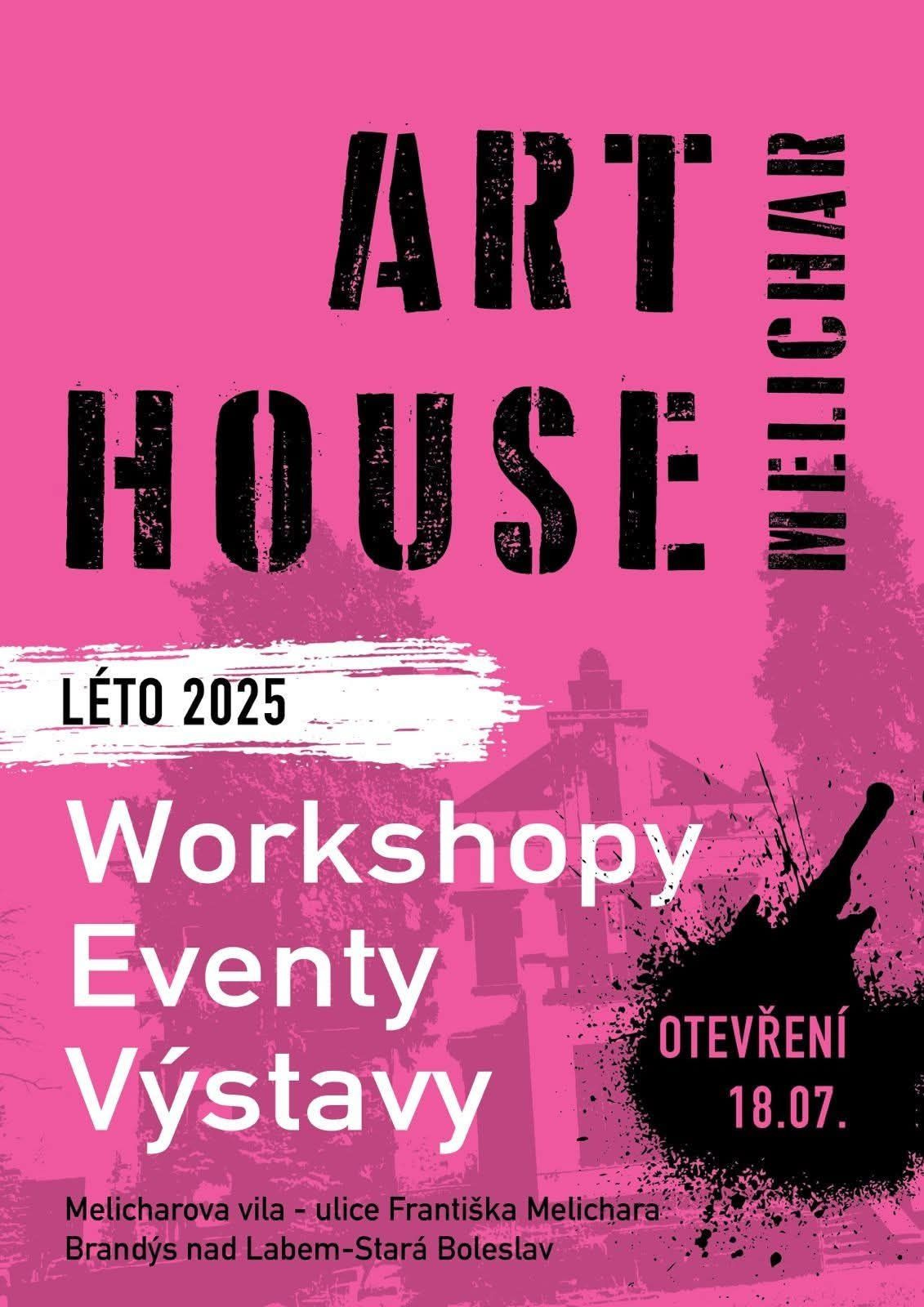

Nové místo pro umění: Art House Melichar

Začnu ale osobním pozváním. Vždycky mne mrzelo, že co se vizuálního umění týká, není v Brandýse-Boleslavi mnoho nabídek. Galerie by se tu prý neuživila. Tak jsme si jednu pořídili. Alespoň na léto. Vypůjčili jsme si nádhernou vilu brandýského průmyslníka Františka Melichara a do konce září v ní budeme provozovat Art House Melichar, místo pro setkávání umělců, pro pořádání workshopů, výstav a kurzů. Kalendáře workshopů se již plní, postupně budeme přidávat i další akce, vše najdete na webu Art House Melichar.

Co si dejte do kalendáře, je pátek 18. července, kdy v 16:00 Art House otevřeme. Bude tu hezký program a především vás vilou osobně provedu. Bude to ojedinělá možnost se do vily podívat, takže přijeďte autem či autobusem klidně i z Prahy. Info o akci zde.

Akci pořádáme s Ivou McGreevy a jejím manželem Paulem, Iva je kurátorka celé záležitosti, Paul vdech akci její výtvarnou podobu. Ivě se ozvěte, pokud jste umělec a přemýšlíte, že byste se nějak zapojili.

Workshop tvůrčího psaní s Elen a se mnou

A již týden před slavnostním otevřením zde budeme s Elen pořádat workshop tvůrčího psaní, třídenní akci zaměřenou na psaní, odbourávání bloků, zlepšování svých textů. Workshop můžete objednávat zde. I to je dost ojedinělá věc a pokud chcete svoje psaní posunout, je to velmi dobrá příležitost, jak využít letní víkend.

Videorozhovor s Jakubem Horákem o bitcoin kauze

Jakub Horák mne pozval do svého podcastu a hovořili jsme především o kryptotržištích, bicoinové kauze a dalších temných stránkách internetu. Podcast Jakuba Horáka si můžete objednat zde, a přinášíme větší videoukázku z podcastu. Jakub Horák měl zrovna narozeniny, tak jsme si dali gin s tonicem (recept z větší části bez tonicu) - a i když je rozhovor dva týdny starý, rozebíráme v něm věci, které teprve nyní v médiích plavou na povrch. A rozhovor mi připomíná, že už jsem chytil pražštinu, už dávno nemluvím tak spisovně, jak bych měl, měl bych na tom zapracovat.

Článek o bitcoinech na Marigoldovi strhl rekordní čtennost - tak vysokou, že mne statistická služba Clicky odstřihla (free režim nemá rád vysokou návštěvnost). Celkem si článek přečetlo přes 160 000 lidí, pak se návštěvnost přestala sledovat.

Situace na digitální AI frontě se zahušťuje

Před týdnem Meta zaplatila 15 miliard dolarů za 49 % společnosti Scale.ai, včetně jejího generálního ředitele, zatímco zatímco většina klientů nyní zřejmě odejde. Ze Scale.ai se má stát nové středisko superinteligence v Metě.

Tento týden se objevily zprávy, že se Meta snaží najmout Nate Friedmana (bývalého generálního ředitele GitHubu) a Daniela Grosse (spoluzakladatele Safe Superintelligence Ilji Sutskevera) a odkoupit jejich fond pro investice do umělé inteligence. Sam Altman tvrdí, že Meta nabízí zaměstnancům OpenAI pracovní smlouvy v hodnotě 100 milionů dolarů. Výsledek to mělo: Meta přetáhla tři pracovníky curyšské kanceláře OpenAI. Meta také jednala o koupi Safe Superintelligence (která byla při poslední investicii ohodnocena na 32 miliard dolarů), Thinking Machines (10 miliard dolarů) a Perplexity.

I kdyby se všechny tyto transakce uskutečnily, stále by to bylo méně než 10 % Facebooku, které Mark Zuckerberg zaplatil za WhatsApp. Proč takové investice? Po pravdě hlavně proto, že firemní model Llama 4 byla zklamáním a Zuck je odhodlán se dostat do vedoucí pozice, ať to stojí cokoli, protože alternativou by mohlo být, že skončí jako Blackberry. A na frontě prosazení nových technologií se mu vůbec nedaří. Investice společnosti Meta do AV a VR se po více než deseti letech blíží 100 miliardám dolarů a stále jsou roky od toho, než se prosadí. Inovační potenciál samotné Mety je pramalý, takže Marku Zuckerbergovi nezbývá, než chodit po trhu s naditou taškou peněz a zkoušet přemlouvat všechny, že zvěsti o příšerné firemní kultuře Facebooku jsou nadsazené, jich by se netýkaly nebo by se alespoň s těmi penězi daly zvládnout. A tím zvyšuje zahřátí trhu s AI lidmi a společnostmi...

AI, degenerace modelu a digitální azbest

Ve čtvrtek jsem byl na zakončení školního roku na základce svých dětí. Každý ročník předváděl nějaké divadelní vystoupení. Prváčci se tam motali, část z nich si nepamatovala text, další část pohyby, z pozadí jim dávala pokyny paní učitelka, že mají třepotat rukama nad hlavou. Nekoordinovanost sama i přes to, jak se s tím museli nadřít. Stejně se tleskalo. Druháci už trochu obstojně uměli text i pohyby, třeťáci a čtvrťáci ještě líp, šestá třída už si dokonce napsala sama vcelku vtipné texty a osmáci zkoušeli improvizaci. Byly tam vtipné momenty, ale šlágr na nově by z toho nebyl.

Hodně mi to připomínalo stav umělé inteligence. Ostatně, učení dětí a umělé inteligence je propojené - vlastně probíhá hodně stejně. Přijde někdo chytrý a pořád do kolečka vysvětluje, jak co má být, opravuje pohyby, dává odezvu a vysvětluje.

Otázka je, co se stane, když takhle necháte učit se samotné děti? Samotné myslím samotné - když je necháte zavřené, bez kontaktu se světem, aby se naučili dělat tu improvizaci? Jak se mohou naučit něco, co nikdo z nich neumí?

Exponenciální růst schopností AI?

Moderní teorie umělé inteligence říká silou stovek miliard dolarů do AI investovaných, že to půjde. Že krůček za krůčkem bude AI zkoušet slepé cesty, dedukovat a odhalovat příležitosti a silou spálené elektřiny a rozehřátého křemíku přijde na věci, jaké nám jako lidstvu zůstaly utajeny.

Jenže opravdu je tomu tak? Pochybnosti se přeci neustále zvětšují. Navzdory všem investicím jsou i nejlepší modely neschopné porozumět světu nad rámec dat, která jim byla při tréninku poskytnuta. A postrádají cokoliv, co bychom mohli nazvat inteligencí. Jsou pouze stochastickým papouškem, nástrojem, který vybere nejčastěji při výuce zmiňovaná data. To dnes sotva stačí k tomu udělat rutinní programátorský úkol. Ale bude to dost pro průlomové objevy?

Co je Stochastický papoušek? Americká počítačová lingvistka Emily Benderová jej definuje jako "systém pro náhodné sešívání sekvencí jazykových forem, které vypozoroval ve svých rozsáhlých tréninkových datech, podle pravděpodobnostních informací o tom, jak se kombinují, ale bez jakéhokoli odkazu na význam".

Spoluautorkami tohoto článku v roce 2021 byly také Timnit Gebru a Margaret Mitchell pracující v té době ve společnosti Google. Výsledek? Obě propuštěny - dosti detailně jsem to tehdy sledoval (i když nakonec spíše za konflikt ohledně publikace a způsobu komunikace s vedením). Jenže zatímco Timnit Gebru a M. Mitchell se věnovaly především etice umělé inteligence, Benderová se dnes zaměřuje na onu "inteligenci". A kdyby dělala v Google, už by ji také vyhodili, naštěstí dělá na Wasthingtonské univerzitě, kde vede Laboratoř počítačové lingvistiky.

Ani programování s AI nedosáhlo zatím excelence…

Pokud Patrickův newsletter sledujete delší dobu, víte, že pravděpodobnost dosažení kritického zrychlení v podobě například univerzální umělé inteligence, nebo alespoň samoučící se inteligence, se zabývám "od pravěku". A přes impozantní pokroky jsem stále značný pesimista. V květnu jsem se přidal k těm, kdo zpochybňovali "exponenciální růst schopností AI" a neustále dokola připomínám příklad programování s AI. Do programování pomocí AI se nasypaly doslova desítky miliard dolarů. Všechny hlavní AI společnosti se jím údajně masivně zabývají a věřil bych jim to. Kdyby se podařilo programování přehodit na AI, znamenalo by to obrovský náskok a úspory. Kde jinde by se spoelečnosti programující AI měly angažovat, než v nástrojích pro programování AI pomocí AI?

Jenže výsledky jsou ... rozpačité. Jasně, je super, že i lidé jako já se bez listování v manuálu napojí na API, odešlou do něj data a zobrazí je na obrazovce, ale to není žádná vysoká programátorština. Kdybych pár minut listoval manuálem a použil příklad v dokumentaci, dokázal bych totéž. Jen pomaleji a ... nechtělo by se mi to podstupovat.

Jak vypadá dnešní programování s podporou AI? Napojit se na databázi je problém. Většina vibecoding platforem se bez uzardění napojí na databázi z prohlížeče administrátorským heslem, pokud jej ví. Odladit něco bezpečnějšího trvá relativně dlouho. A když se to podaří, tak si to při nejbližší příležitosti dotyčný nástroj zase smaže a začínáte odznovu. Bez zkušeností, v jakém pořadí co vytvářet, bývá setkání s vibecodingem pro běžného programátora poněkud tristní. Prostě to připomíná ty druháčky, kteří na pódiu mávají rukama a tu a tam se někomu z nich podaří trefit do správné repliky či pohybu...

Jak se má AI vlastně učit? A od koho???

A tím se dostáváme k druhému dílu mého pesimismu. Jak vlastně umělá inteligence má vzdělávat?

Lidské "vzdělávání", tedy proces objevování, nebyl jednoduchý proces. Obecně se soudí, že se zrychlilo teprve v posledních řekněme 300 letech, tedy od průmyslové revoluce. Ale tak to vůbec není. Lidstvo mělo své periody objevování nahoru a dolů, pro mne jsou skvělým příkladem Achnatonovské reformy (do 1350 př.n.l) zajímavé mimo jiné tím, že po Achnatonově smrti bylo vše vědění a "novoty" za jeho reforem (ačkoliv převážně kulturně-náboženských) vzniklé systematicky zavrženo a zapomenuto. Takových vln, vlnek a zapomenutí bylo v dějinách celá řada. V poslední době znovu mezi historiky nabyla určité popularity teze, zda v těch stamilionech let pozemské existence nemohla existovat vrcholná technologická civilizace, která beze stopy zmizela. Nápověda: pokud by to bylo před miliony let, tak mohla, protože všechny stopy po ní včetně znečištění, by zmizely. Ačkoliv je Silurská hypotéza spíše myšlenkový experiment, připomíná nám, že lidské zkoumání a objevování nemusí být ani přímkou, natož exponenciálou.

Co bývá zdrojem takovýchto kroků zpět? Zpravidla je to závada na zpětnovazební smyčce. Čili to, že se prospěšnost či platnost nové myšlenky či objevu nepodaří potvrdit dříve, než je zadupána těmi, jimž prospívá stávající stav. A tohle byl obrovský průlom evropské vědy převzatý z islámského zlatého vědu a od "prvního vědce" Alhazena: schopnost zformulovat hypotézu, postup jak ji empiricky ověřit a jak věcně kritizovat jak hypotézu, tak postup jejího ověření. Zatímco například čínská učenost byla založena na autoritě učitele, evropské osvícenství přineslo využilo starší arabský cyklus hypotézy a jejího empirického ověření. Jak je možné, že islámská věda nakonec upadla, když přišla s něčím tak důležitým? Mnoho faktorů: především pád Bagdádu 1258 a vliv mongolských invazí, ale také vznik a rozvoj energetických přebytků v Evropě: od zavedení radlice a pluhu, což umožnilo využívat úrodné jílovité půdy střední a severní Evropy. Zavedení chomoutu, který umožnil podstatně lépe využívat zvířecí sílu, přes využívání vodní síly, až třeba po náhradu dřeva uhlím.

Umělá inteligence to zatím má poněkud jinak. Neustále je "vzdělávána" na první pohled nekončícím přísunem učebních materiálů. V USA rozhodl kalifornský soud dne 24.6.2025 v případě Andrea Bartz, vs. Anthropic, že lze použít knihy pro učení AI, neboť je to v rámci fair use. Jenže soudce také potvrdil, že to se týká jednotlivých použití. Ne toho, co prováděl Anthropic, který ukládal více než 7 milionů pirátských knih v "centrální knihovně". To podle soudu porušilo autorská práva autorů a nebylo fair use. Soudce nařídil soudní proces v prosinci k určení, kolik Anthropic dluží za porušení zákona.

Jenže i poté, co se "sdílení knih s AI" stalo normou, za jakou ještě před pár lety soudu téměř upalovaly pirátské šiřitele knih, se ukazuje, že vysychá zdroj znalostí, které lze ke vzdělávání AI používat. Stále častěji se používají nejrůznější materiály z internetu včetně těch, které bychom označili za deepfake a které dokonce vytvořila umělá inteligence. Může tohle fungovat? Lze se AI vzdělávat na svých vlastních materiálech?

Otrávené studně a digitální azbest

Dlouhodobě se ukazuje, že je to problém. Hovoří se o problému "otrávených studní" nebo "digitálního azbestu" - tedy materiálu, který se kdysi považoval za dokonalý, než se přišlo na to, že není jen inertním izolantem, ale také tím, co způsobuje rakovinu. Jak se může AI vzdělávat z materiálů, které si sama vyhalucinovala? Bude existovat nějaká AI zpětnovazebná vědecká smysl, jakou vznikala věda v Evropě? Tím myslím smyčka, kterou si zvládne vytvořit sama AI, ne že jí zástupy vědců budou značkovat jí samou vymyšlená (a často vyhalucinovaná) data a budeme tomu hrdě říkat "reinforced learning". Zatím spíše vnímáme degenerující zpětnou vazbu v rámci AI modelů a jevu se začíná říkat kolaps modelu, anglicky Model Collapse.

AI totiž má podobný problém, jako někdejší islámská věda. Ta byla v třináctém století centralizovaná a prakticky se v ní nerozvíjely konkurenční myšlenkové směry. Stejně je na tom dnešní AI: existují jednotky společností, které vytvářejí AI modely, ve skutečnosti se bedlivě sledují a co udělá jedna, okamžitě kopírují ty zbývající. Nové postupy se objevují, ale jsou do nich vkládána nepřiměřená očekávání, často vyhypovaná i konkurenčními společnostmi, které rychle přispěchávají s tvrzením, že technologii také mají a že budou jistě přelomové, protože taková tvrzení dávají trhu na důvěryhodnosti. Jedinou malou výjimkou jsou čínské společnosti jako DeepSeek, jejíchž hlavní moment překvapení ale také vyprchal.

Takto vzdělávané modely se stávají otrávenými svou vlastní projekcí reality. "Reinforcement learning from human feedback" (RLHF) není skutečnou zpětnou vazbou, ale pouze projekcí lidských preferencí. AI chybí empirické testování, nemá žádný způsob, jak ověřit své hypotézy proti realitě. A to je velmi zásadní omezení. Jak AI ověří, co je skutečné? Jak může fyzicky interagovat se světem? Takto vznikají chyby, které se akumulují a exponenciálně zesilují. Zkrátka řečeno má AI chybnou epistemologickou základnu, neboť se trénuje na vlastních halucinacích.

Pokud se tento trend nezastaví, AI pravděpodobně zažije svou vlastní verzi "mongolských invazí" - model collapse povede k dramatickému snížení užitečnosti systémů. Na rozdíl od islámské vědy, kde znalosti byly ztraceny postupně, AI kolaps může být rychlý a náhlý. Ne snad, že by se AI vytratila ze scény, ale nejprve by začaly modely postupně "hloupnout" a jejich výsledky by se výrazně zhoršovaly. V raném model collapse začíná model ztrácet informace v krajních hodnotách distribuce – tedy menšinová data, kdy zapomíná specializované postupy. Dále by narůstala míra halucinací (jak se děje v modelu o3).

Může se něco takového stát?

Jistě, že může. Nebylo by to poprvé. Firmy by nadále tlačily obrovské peníze do AI, aby "dočasné obtíže" zlomily, ale reálná produktivita AI nástrojů by klesala. AI kolaps by mohl být "neviditelný" a postupný. Systémy by stále vypadaly funkčně, ale jejich skutečná užitečnost by postupně klesala. Lidé by si zvykli na nižší kvalitu a považovali by ji za normální. AI by nikdy nepřekročila stín lidského pomocníka, který načrtne text, dodělá kus kódu nebo vymyslí ilustrační obrázek.

Stane se něco takového? Jistě, je celá řada postupů, jak se alespoň teoreticky "digitálnímu azbestu" bránit. AI společnosti rychle vyvíjejí způsob, jak rozpoznávat obsah AI vytvořený nebo jak jej označit a již dále nepoužívat. Pracují na kombinování syntetických (uměle vytvořených) učebních dat s reálnými daty, což zřejmě může bránit degradaci modelu. A jsou tu i světlé perspektivy. Nejnovější modely vykazují schopnosti, které nebyly explicitně natrénovány (chain-of-thought reasoning, few-shot learning). Velkým průlomem by mohly být také roboti a autonomní systémy, kteří by poskytovali empirickou zpětnou vazbu ze skutečného světa. Ale bude to dost?

Zatím je tento scénář podle mého soudu pravděpodobnější, než to, že AI ovládne či vyhladí lidskou civilizaci, jak modeluje AI 2027. Jenže nejásejte: výsledek podle mne nebude tak dramatický ani na jednu stranu. Ačkoliv univerzální umělá inteligence AGI do roku 2030 nepřijde (nezměníme-li definici), stejně tak AI dramaticky nezhloupne. Proti každé síle působí protisíla. AI bude pravděpodobně procházet krizemi, ale spíše ve stylu "punctuated equilibrium" než totálního kolapsu.

Ne, ve skutečnosti milion opic, který mlátí do milionu psacích strojů, nemůže za milion let napsat Sen noci svatojánské.

PS: Přečtěte si můj článek o tom, co ze Zamrzlá evoluce ve světě techniky.

PPS: a jako odpověď na tento email mi napište, co si o tom myslíte vy.

AI a provoz na webu

Před rokem Cloudflare nabídl svým zákazníkům webhostingu možnost blokovat AI boty, aby nemohly bez povolení kopírovat obsah webových stránek a používat data k trénování modelů strojového učení. To byla významná nabídka, Cloudflare přenáší zhruba 10 % dat na světovém internetu. Letos k tomu přidal funkci nazvanou AI Labyrinth.

Šéf Cloudflare Matthe Prince se nyní objevil v médiích, když tento týden rozdával hovory na akci ve francouzských Cannes. Odkazy z vyhledávačů prudce klesly, protože lidé stále více spoléhají na AI shrnutí pro odpovědi na své dotazy, což nutí mnoho vydavatelů přehodnotit své obchodní modely. Před deseti lety Google procházel dvě stránky za každého návštěvníka, kterého poslal vydavateli, říká Prince a dodává, že před šesti měsíci:

Pro Google byl tento poměr 6:1

Pro OpenAI to bylo 250:1

Pro Anthropic to bylo 6 000:1

Nyní to ale je takto:

Pro Google je to 18:1

Pro OpenAI je to 1 500:1

Pro Anthropic je to 60 000:1

Zatímco vyhledávače a AI chatboti zahrnují odkazy na původní zdroje, vydavatelé mohou získat příjmy z reklamy pouze pokud čtenáři prokliknou. "Lidé za posledních šest měsíců více důvěřují AI, což znamená, že nečtou původní obsah," řekl Prince. "Budoucnost webu bude stále více podobná AI, a to znamená, že lidé budou číst shrnutí vašeho obsahu, ne původní obsah."

Sám to vidím na Marigoldovi, kde jsem přestal používat některé analytické nástroje, protože mi měřily obrovskou návštěvnost, jenže když jsem ji očistil o nejrůznější boty, té skutečné lidské návštěvnosti mi zůstalo podstatně méně.

Jednohubky

Andrej Karpathy poskytl velký rozhovor na AI Startup School (zde na Youtube). Hovořil o vibecodingu, o proměnách ve vývoji software i o tom, že dnešní AI připomíná svět IT v šedesátých letech. Je dobré si rozhovor dát pro kontext.

Velká panika kolem PowerPointu v roce 2003 se jmenuje článek z The Atlantic. Článek srovnává srovnává "paniku z PowerPointu" s dnešními obavami o sociální média. V roce 2003 se PowerPoint stal terčem kritiky poté, co NASA vyšetřovací zpráva o havárii raketoplánu Columbia částečně obvinila PowerPoint prezentace z toho, že zakryly kritické bezpečnostní informace. Špatně strukturované slidy podle zprávy přispěly k tomu, že manažeři nepochopili závažnost situace...

Uber jedná s Travisem Kalanickem, spoluzakladatelem společnosti, o financování akvizice americké dceřiné společnosti čínské firmy Pony.ai, která se zabývá vývojem autonomních vozidel. Kalanick byl před osmi lety v důsledku převratu v představenstvu donucen opustit Uber. Poté založil společnost CloudKitchens, kde zůstane i v případě, že se transakce uskuteční. Pony.ai má povolení k provozování robotických taxi a nákladních vozidel v USA a Číně. Pokud bude dohoda uzavřena, Kalanick bude Pony.ai řídit.

OpenAI odstranila z webu zmínky o spolupráci s bývalým šefdesignerem Apple Johny Ive. Nejde o rozchod, na firmu se obrátil startup iyO, který si stěžuje, že jim Ive ukradl jejich vynález, totiž AI sluchátka. No uvidíme, situaci rozebírá MacRumors. Nicméně ano, i sluchátka by byl velmi zajímavý wearable doplněk s AI!

Google spustil svého agenta pro programování s AI v příkazové řádce. Jmenuje se (nepřekvapivě) Gemini CLI a vypadá stejně, jako Claude Code nebo OpenAI Codex. Hlavní výhoda? Štědrá porce dotazů zdarma. Píšu o něm zde. Zkušenost? Zatím o generaci slabší, než Claude Code, ale ta štědrá porce se na hrubé kódování hodí. Můj pracovní setup: na jednom monitoru jedu vibecoding, kde mám 4 okna (VS Code či Cursor, Gemini CLI, Claude Code a Lovable) - a tam odklikávám, co je potřeba. Na druhém monitoru pracuju. Dobře mi tvorba kravinek nahradila potulování po sockách. Například jsem takhle konečně dotahoval svůj analytický modul pro specifikace 3GPP, které pořád (už 30 let!) sleduju. Něco jsem dal ven, ale ještě na tom pracuju, zrovna jsem to rozvrtal...

Tak a to je pro dnešek vše.

Vše nejlepší do nového týdne přeje

Patrick Zandl

PS: newsletter byl rozeslán na 4839 adres odběratelů.